- Registriert

- 17. Jan. 2018

- Beiträge

- 41

- Reaktionspunkte

- 6

- Punkte

- 8

Hallo zusammen,

nachdem ich (mal wieder) die diversen Threads zum SSD-Cache durch habe, wollte ich hier auch meine Erfahrungen teilen und Eure Einschätzung zu meiner Situation bekommen.

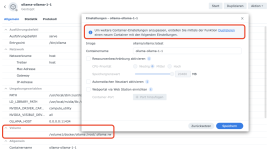

Ich hatte mich trotz des allgemeinen Tenors hier für einen SSD-Cache entschieden, habe seit ca. 2 Jahren einen 2x500GB M2 Schreib-/Lesecache aktiv mit Crucial P3 SSDs.

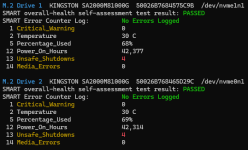

Seit letzter Woche bekomme ich bei einer der SSD die EoL-Meldung (TBW überschritten), ich vermute die zweite baugleiche wird demnächst auch kommen. Mittlerweile sind auch dafür optimierte SSDs (WD RED) bezahlbar, die deutlich (!) höhere TBW-Werte haben, als meine aktuellen (ca. 110TBW vs. 500 bzw 1000TBW je nach Größe).

Während dieser 2 Jahre lief der Cache ohne Beanstandungen oder Auffälligkeiten. SSD-Cache-Trefferquote liegt dauerhaft bei 98-100%. So weit zum Erfahrungsbericht.

Daher stehe ich gerade vor der Entscheidung, den Cache zu erneuern oder ganz zu deaktivieren.

Noch einige Sätze zu meiner Situation:

Ich nutze vor allem Home Assistant als Container, dort eine vergleichsweise große/aufwändige Installation. Ansonsten ein paar Container und eine VM, jeweils nur Verwaltungszeug (AdBlocker, Unifi-Controller usw.).

Meine DS920+ hat 20GB RAM bekommen und eben den SDD-Cache. Ich hatte mir davon vor allem auch Entlastung der HDDs (3x8TB) versprochen, da speziell Home Assistant ja schon dauerhaft I/O hat. Ich überlege daher, ob die 20GB RAM alleine (davon sind ca 13GB "Zwischengespeichert" laut System Monitor) dafür ausreichen, dass I/O-intensive Dinge einfach im RAM gehalten werden und ich mir mit dem SSD-Cache nur sinnlos die SSDs totschreibe, oder ob ich damit eben außerhalb der NAS-Funktion alle Container/VM-Geschichten abfedern kann.

Ich hatte mich explizit gegen M2 als zusätzliches Volume entschieden, da es einen deutlich höheren Konfigurationsaufwand bedeutet (speziell für Container und VMs) und nicht offiziell unterstützt wird (zukünftig also potentiell mal nicht mehr funktioniert und ich es dann rückbauen müsste).

Ich bin auf Eure Einschätzungen gespannt!

nachdem ich (mal wieder) die diversen Threads zum SSD-Cache durch habe, wollte ich hier auch meine Erfahrungen teilen und Eure Einschätzung zu meiner Situation bekommen.

Ich hatte mich trotz des allgemeinen Tenors hier für einen SSD-Cache entschieden, habe seit ca. 2 Jahren einen 2x500GB M2 Schreib-/Lesecache aktiv mit Crucial P3 SSDs.

Seit letzter Woche bekomme ich bei einer der SSD die EoL-Meldung (TBW überschritten), ich vermute die zweite baugleiche wird demnächst auch kommen. Mittlerweile sind auch dafür optimierte SSDs (WD RED) bezahlbar, die deutlich (!) höhere TBW-Werte haben, als meine aktuellen (ca. 110TBW vs. 500 bzw 1000TBW je nach Größe).

Während dieser 2 Jahre lief der Cache ohne Beanstandungen oder Auffälligkeiten. SSD-Cache-Trefferquote liegt dauerhaft bei 98-100%. So weit zum Erfahrungsbericht.

Daher stehe ich gerade vor der Entscheidung, den Cache zu erneuern oder ganz zu deaktivieren.

Noch einige Sätze zu meiner Situation:

Ich nutze vor allem Home Assistant als Container, dort eine vergleichsweise große/aufwändige Installation. Ansonsten ein paar Container und eine VM, jeweils nur Verwaltungszeug (AdBlocker, Unifi-Controller usw.).

Meine DS920+ hat 20GB RAM bekommen und eben den SDD-Cache. Ich hatte mir davon vor allem auch Entlastung der HDDs (3x8TB) versprochen, da speziell Home Assistant ja schon dauerhaft I/O hat. Ich überlege daher, ob die 20GB RAM alleine (davon sind ca 13GB "Zwischengespeichert" laut System Monitor) dafür ausreichen, dass I/O-intensive Dinge einfach im RAM gehalten werden und ich mir mit dem SSD-Cache nur sinnlos die SSDs totschreibe, oder ob ich damit eben außerhalb der NAS-Funktion alle Container/VM-Geschichten abfedern kann.

Ich hatte mich explizit gegen M2 als zusätzliches Volume entschieden, da es einen deutlich höheren Konfigurationsaufwand bedeutet (speziell für Container und VMs) und nicht offiziell unterstützt wird (zukünftig also potentiell mal nicht mehr funktioniert und ich es dann rückbauen müsste).

Ich bin auf Eure Einschätzungen gespannt!

--> weniger relevant in meinem Fall

--> weniger relevant in meinem Fall