- Mitglied seit

- 05. Jul 2015

- Beiträge

- 131

- Punkte für Reaktionen

- 14

- Punkte

- 24

Hallo,

ich hatte vor ein paar Jahren schon mal einen Beitrag geschrieben dieser ist aber bereits geschlossen, daher konnte ich heute nicht weiter schreiben.

Was habe ich:

- DS1221+ mit Internet Zugang ohne Portweiterleitung etc.

- Webspace wo ich per FTP Zugriff habe

Was möchte ich:

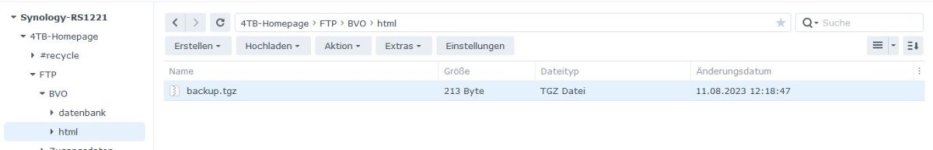

- Daten von verschiedenen Webspace (Domains) sichern auf die DS. Nach Möglichkeit auch dies z.B. 1x die Woche oder 1x im Monat so das es auf der DS verschiedene z.B. Ordner gibt nach Datum/Versionen

Frage:

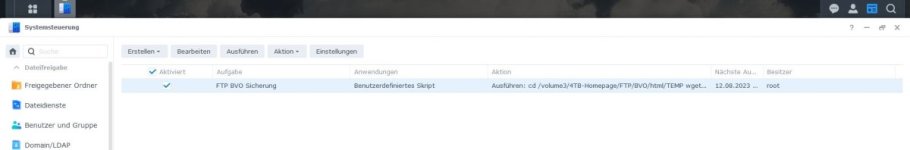

1.Es gibt kein Programm/App bei der DS die dies kann?

2. Muss ich dies per wget machen, wenn ja wie?

3. Muss ich eine Portweiterleitung einrichten wenn ich das per FTP mache?

4. Was habe ich übersehen bis jetzt?

Danke schon einmal für Eure Hilfe bzw. Tips.

ich hatte vor ein paar Jahren schon mal einen Beitrag geschrieben dieser ist aber bereits geschlossen, daher konnte ich heute nicht weiter schreiben.

Was habe ich:

- DS1221+ mit Internet Zugang ohne Portweiterleitung etc.

- Webspace wo ich per FTP Zugriff habe

Was möchte ich:

- Daten von verschiedenen Webspace (Domains) sichern auf die DS. Nach Möglichkeit auch dies z.B. 1x die Woche oder 1x im Monat so das es auf der DS verschiedene z.B. Ordner gibt nach Datum/Versionen

Frage:

1.Es gibt kein Programm/App bei der DS die dies kann?

2. Muss ich dies per wget machen, wenn ja wie?

3. Muss ich eine Portweiterleitung einrichten wenn ich das per FTP mache?

4. Was habe ich übersehen bis jetzt?

Danke schon einmal für Eure Hilfe bzw. Tips.