was wäre das so für Transferraten möglich? hast du da eine Ziffer?

nur mal so, interessehalber

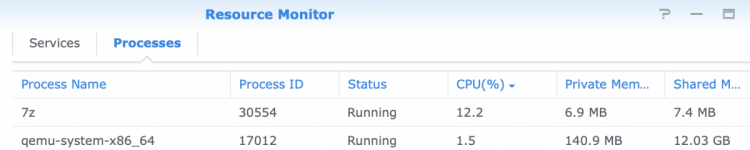

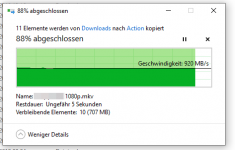

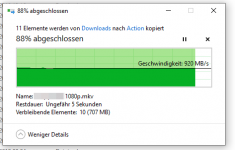

PC >>>> RS1221+

mehr schafft der PC nicht.

So viel zur Frage was möglich wäre.

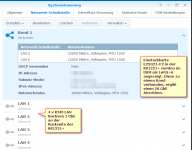

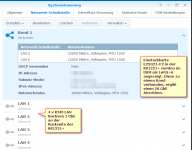

Die E25G21-F2 kann ich leider nur in der langsamen Verbindung anbinden, die Karte selbst hat SFP28 Einschübe, also 2 x 25 GbE, das wären im Bond 50 GbE.

Ich kann aber nur SFP+ ( 10 GbE) verbinden, die im Bond ergeben oben die 20 GbE Verbindung.

Wie schon erwähnt wurde, mit 10 GbE geht es gut, ABER leider noch nicht so weit verbreitet und die Preise der erforderlichen Komponenten sind ggü. 1 GbE enorm hoch im Vergleich.

Nicht zu Unterschätzen die Abwärme welche durch die 10 GbE Teile entsteht!

Braucht man es, nein.

Es ist dzt immer noch eine techn. Spielerei. Ich kopiere hauptsächlich Videos von der gopro mit privaten Aufnahmen der Kids und natürlich ging das auch bisher mit ~ 115 MB/s (1 GbE) aber mit 10 GbE geht es deutlich schneller.

Bei der ersten Übertragung war ich nicht mal sicher ob überhaupt etwas kopiert wurde, ich war das "Warten" auf das Ende vom Kopiervorgang schon gewöhnt mit 1 GbE.

Aber noch mal, der Preis ist enorm welchen man dzt für eine vernünftige 10 GbE Verbindung bezahlt im Vergleich zu 1 GbE Anbindungen.

Ebenso die Wärme die dabei produziert wird!