- Registriert

- 19. Feb. 2018

- Beiträge

- 470

- Reaktionspunkte

- 53

- Punkte

- 28

Hi zusammen,

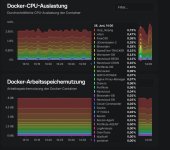

ich habe die Situation, dass wenn ich z.B. was großes (ca. 80GB große Datei) von meinem NAS auf den PC kopiere die Docker container währenddessen neu starten.

Soweit ich weiß gab es diesen Fall schon einmal, wo JDownloader2 was großes entpackt hat.

Weiß jemand wie ich das nun am besten eingrenze woran das liegen kann?

Sieht für mich so aus als tritt das nur bei großer Belastung auf.

DS716+

14% Feier Speicherplatz (=1,5TB), Btrfs, RAID 0

RAM 8GB (erweitert)

ich habe die Situation, dass wenn ich z.B. was großes (ca. 80GB große Datei) von meinem NAS auf den PC kopiere die Docker container währenddessen neu starten.

Soweit ich weiß gab es diesen Fall schon einmal, wo JDownloader2 was großes entpackt hat.

Weiß jemand wie ich das nun am besten eingrenze woran das liegen kann?

Sieht für mich so aus als tritt das nur bei großer Belastung auf.

DS716+

14% Feier Speicherplatz (=1,5TB), Btrfs, RAID 0

RAM 8GB (erweitert)

Symptome aus dem Log (analysiert mit Chatgpt:

Symptome aus dem Log (analysiert mit Chatgpt: Technische Engpässe deiner DS716+

Technische Engpässe deiner DS716+ Warum es knallt:

Warum es knallt: