- Registriert

- 09. Juni 2025

- Beiträge

- 11

- Reaktionspunkte

- 1

- Punkte

- 3

Hallo an die Community

ich suche eine Backup Anwenderung, mit der ich automatisiert folgende Backup Strategie auf meinen 1821+ ausführen kann:

- Ich will einen neuen leeren Speicherpool aus 2 Festplatten erstellen mit einen leeren Volumen ( Volumen ist größer als die gesammtkapazität aller anderen Volumen ) .

) .

- Auf diesen Pool will ich in gewissen Zeitabständen ein Backup bzw Kopie aller Daten von den anderen Speicherpools im NAS speichern.

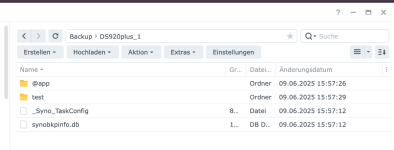

- Die Daten sollen allerdings als reine Daten vorliegen, nicht als Backup Containen, sprich die sollen nur automatisiert kopiert werden.

- Nach dem initialen Sicherungsvorgang sollen dann bei jeden Sicherungsvorgang natürlich auch dann nur die Daten überschrieben werden, die sich seit dem letzten Sicherungslauf geändert haben.

Ich habe hier im Forum und auch schon im Synologie Paketzentrum gesucht, aber ich habe weder ein Thema gefunden, welches so einen UseCase konkret wiederspiegelt noch hab ich in den Paketen etwas gefunden, wo solch eine Funktionalität beschreiben wird.

Daher die Frage an euch, ob ihr eine entsprechende App kennt,

Was ich nicht möchte:

- Anleitung für Raid1 (ich möchte keine sofortige Syncnisierung!)

- Scripte / Befehle, die per Telnet / ssh eingerichtet werden. (ich bin zu vergesslich um das immer zu kontollieren, außerdem fallen Probleme gerade bei so einen System dann nur sehr schwer auf, wenn man nur über die Oberfläche geht etc.)

Ich hoffe ihr könnt mir hier weiterhelfen.

Vielen Dank schon einmal im Voraus

ich suche eine Backup Anwenderung, mit der ich automatisiert folgende Backup Strategie auf meinen 1821+ ausführen kann:

- Ich will einen neuen leeren Speicherpool aus 2 Festplatten erstellen mit einen leeren Volumen ( Volumen ist größer als die gesammtkapazität aller anderen Volumen

) .

) . - Auf diesen Pool will ich in gewissen Zeitabständen ein Backup bzw Kopie aller Daten von den anderen Speicherpools im NAS speichern.

- Die Daten sollen allerdings als reine Daten vorliegen, nicht als Backup Containen, sprich die sollen nur automatisiert kopiert werden.

- Nach dem initialen Sicherungsvorgang sollen dann bei jeden Sicherungsvorgang natürlich auch dann nur die Daten überschrieben werden, die sich seit dem letzten Sicherungslauf geändert haben.

Ich habe hier im Forum und auch schon im Synologie Paketzentrum gesucht, aber ich habe weder ein Thema gefunden, welches so einen UseCase konkret wiederspiegelt noch hab ich in den Paketen etwas gefunden, wo solch eine Funktionalität beschreiben wird.

Daher die Frage an euch, ob ihr eine entsprechende App kennt,

Was ich nicht möchte:

- Anleitung für Raid1 (ich möchte keine sofortige Syncnisierung!)

- Scripte / Befehle, die per Telnet / ssh eingerichtet werden. (ich bin zu vergesslich um das immer zu kontollieren, außerdem fallen Probleme gerade bei so einen System dann nur sehr schwer auf, wenn man nur über die Oberfläche geht etc.)

Ich hoffe ihr könnt mir hier weiterhelfen.

Vielen Dank schon einmal im Voraus