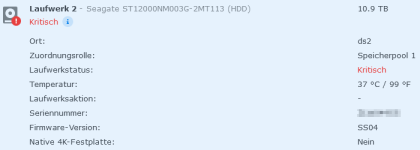

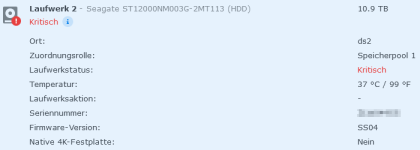

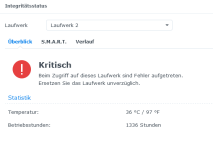

In meiner DS220+ (DSM 7.2.1-69057 Update 3) wird mir seit gestern der Status eines Laufwerks, eine Seagate Exos X16 12TB (ST12000NM003G) als "kritisch" angezeigt. "Beim Zugriff auf das Laufwerk sind Fehler aufgetreten."

Vor drei Tagen hatte ich mehrere "Das System hat einen unerwarteten Stromausfall auf Laufwerk 2 in Volume 1 erkannt." Meldungen. Daraufhin habe, wie empfohlen, den Schreib-Cache deaktiviert.

Ich vermute für beides als Ursache, dass das Netzteil nicht richtig an der DS angeschlossen war und aufgrund dieses Wackelkontakts die Spannung für das Anlaufen der HDD nicht ausreichte. (Beim Anheben der DS fiel der Netzteilstecker hinten einfach runter).

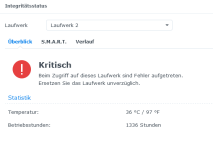

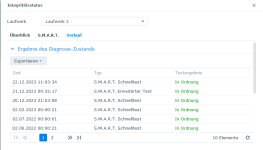

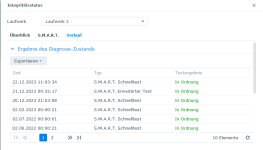

Ansonsten scheint mit der HDD alles in Ordnung zu sein, denn die S.M.A.R.T. Tests (auch einmal "erweitert") laufen ohne Probleme durch, Testergebnis "in Ordnung". Ich würde sie nur sehr ungern tauschen wollen, bei gerade einmal ~1300 Betriebsstunden.

Nun meine Fragen:

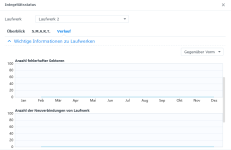

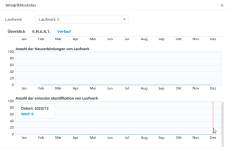

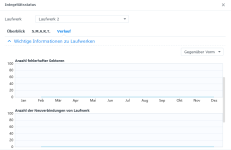

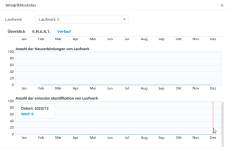

Bei "Anzahl der Neuverbindungen von Laufwerk" und "Anzahl fehlerhafter Sektoren" ist der Wert jeweils auch 0.

Vor drei Tagen hatte ich mehrere "Das System hat einen unerwarteten Stromausfall auf Laufwerk 2 in Volume 1 erkannt." Meldungen. Daraufhin habe, wie empfohlen, den Schreib-Cache deaktiviert.

Ich vermute für beides als Ursache, dass das Netzteil nicht richtig an der DS angeschlossen war und aufgrund dieses Wackelkontakts die Spannung für das Anlaufen der HDD nicht ausreichte. (Beim Anheben der DS fiel der Netzteilstecker hinten einfach runter).

Ansonsten scheint mit der HDD alles in Ordnung zu sein, denn die S.M.A.R.T. Tests (auch einmal "erweitert") laufen ohne Probleme durch, Testergebnis "in Ordnung". Ich würde sie nur sehr ungern tauschen wollen, bei gerade einmal ~1300 Betriebsstunden.

Nun meine Fragen:

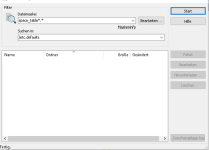

- Ich finde die Details zu den S.M.A.R.T. nicht. Die sollten doch unter Speicher-Manager > HDD/SSD > Laufwerk > Integritätsstatus > S.M.A.R.T. > Details zu finden sein? Nur, "Details" gibt es bei mir nicht, auch nicht beim nicht betroffenen Laufwerk. Werden die nicht mehr angezeigt oder gucke ich falsch?

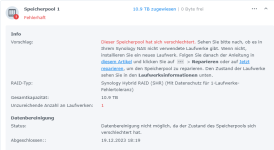

- Kann ich den Status wieder zurückstellen, damit ich das Volume (SHR-1, BTRFS) reparieren kann? DSM verweigert verständlicherweise die Reparatur auf ein defektes Laufwerk. Nur in diesem Fall scheint der Grund für den Fehler doch eher ein Wackelkontakt als eine defektes Laufwerk zu sein.

Bei "Anzahl der Neuverbindungen von Laufwerk" und "Anzahl fehlerhafter Sektoren" ist der Wert jeweils auch 0.