GutFreiEhrlich

Benutzer

- Registriert

- 09. Aug. 2024

- Beiträge

- 8

- Reaktionspunkte

- 5

- Punkte

- 3

Guten Morgen Zusammen!

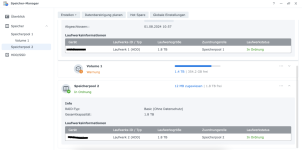

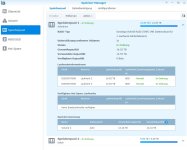

Ich brauche wohl doch nochmal eure Hilfe. Nachdem der zweite Speicherpool erstellt wurde, kann ich jedoch immer noch keine Dateien darauf speichern, weil wohl ein Volume fehlt. Hat jemand von euch eine Idee was ich falsch gemacht habe?

Ich brauche wohl doch nochmal eure Hilfe. Nachdem der zweite Speicherpool erstellt wurde, kann ich jedoch immer noch keine Dateien darauf speichern, weil wohl ein Volume fehlt. Hat jemand von euch eine Idee was ich falsch gemacht habe?