Nach Problemen musste ich bei meiner RS422+ hart die 2 platten die Speicherpool 1 gebildet haben rausziehen. Jetzt konnte ich einen Speicherpool 3 mit den beiden Ersatzplatten erstellen, jedoch steht der Speicherpool 1 als "abgestürzt" drin und lässt sich nicht löschen. Was kann ich tun?

DSM 7.2 Löschen von Speicherpool erzwingen

- Ersteller Andi79

- Erstellt am

-

Ab sofort steht euch hier im Forum die neue Add-on Verwaltung zur Verfügung – eine zentrale Plattform für alles rund um Erweiterungen und Add-ons für den DSM.

Damit haben wir einen Ort, an dem Lösungen von Nutzern mit der Community geteilt werden können. Über die Team Funktion können Projekte auch gemeinsam gepflegt werden.

Was die Add-on Verwaltung kann und wie es funktioniert findet Ihr hier

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

- Status

- Für weitere Antworten geschlossen.

das ist ja gerade das problem, es geht nicht. Beim Volume1 drin ist das löschen ausgegraut, beim Speicherpool selbst ist es anklickbar, es kommt dann aber die Meldung System konnte Speicherpool nicht entfernen, bitte versuchen Sie es erneut.

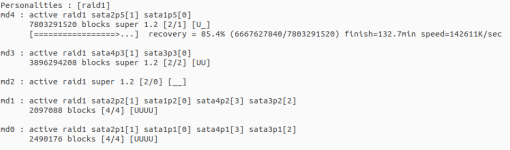

gerade auf der Shell gekuckt, jetzt blick ich ein stück weiter durch. sehe ich es richtig dass er auf jeder platte eine Partition fürs eigene Betriebssystem anlegt und da auf md0 ein raid bildet, das gleiche (für was ist die 2. partition auf jeder platte) auf md1. md2 wäre jetzt mein entferntes raid1, md3 das 2. und md4 mein neues raid mit den platten die die alten ersetz haben. Kann ich gefahrlos per mdadm md2 auflösen oder mag synology das außerhalb der Weboberfläche nicht?

Anhänge

- Registriert

- 27. Sep. 2008

- Beiträge

- 15.491

- Reaktionspunkte

- 4.773

- Punkte

- 533

Ja, ist so. md0 ist der DSM in Partition 1, als Raid1 über alle internen Platten. md1 dito in Partition 2 als Swap.

Erst ab md2, Partition 3 geht's los mit den benutzerdefinierbaren Raid-Typen.

Was da bei dir momentan so abgeht, blicke ich momentan noch nicht. Das verstehst du vermutlich besser als ich. Warte erstmal den Rebuild ab.

Erst ab md2, Partition 3 geht's los mit den benutzerdefinierbaren Raid-Typen.

Was da bei dir momentan so abgeht, blicke ich momentan noch nicht. Das verstehst du vermutlich besser als ich. Warte erstmal den Rebuild ab.

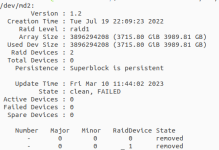

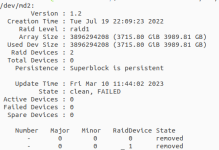

also scheint so ein typisches RAID thema zu sein  . Leider scheint kein lsof zu gehen bei synology, k.a. was da blocken könnte. Problem ist dass ich die vg nicht löschen kann um dann das raid aufzulösen

. Leider scheint kein lsof zu gehen bei synology, k.a. was da blocken könnte. Problem ist dass ich die vg nicht löschen kann um dann das raid aufzulösen

sudo dmsetup remove vg1-volume_1

device-mapper: remove ioctl on vg1-volume_1 failed: Device or resource busy

Command failed

sudo vgremove vg1-volume_1

/dev/md2: read failed after 0 of 4096 at 0: Input/output error

/dev/md2: read failed after 0 of 4096 at 3989805203456: Input/output error

/dev/md2: read failed after 0 of 4096 at 3989805260800: Input/output error

/dev/md2: read failed after 0 of 4096 at 4096: Input/output error

Volume group "vg1-volume_1" not found

Cannot process volume group vg1-volume_1

dementsprechend geht auch

sudo mdadm --stop /dev/md2

mdadm: Cannot get exclusive access to /dev/md2 erhaps a running process, mounted filesystem or active volume group?

erhaps a running process, mounted filesystem or active volume group?

nicht.

Die 2 vg auf md2 sind noch angelegt: vg1-syno_vg_reserved_area vg1-volume_1

irgend ne idee wie ich ohne lsof anzeigen lassen könnte was die vg noch belegt?

. Leider scheint kein lsof zu gehen bei synology, k.a. was da blocken könnte. Problem ist dass ich die vg nicht löschen kann um dann das raid aufzulösen

. Leider scheint kein lsof zu gehen bei synology, k.a. was da blocken könnte. Problem ist dass ich die vg nicht löschen kann um dann das raid aufzulösensudo dmsetup remove vg1-volume_1

device-mapper: remove ioctl on vg1-volume_1 failed: Device or resource busy

Command failed

sudo vgremove vg1-volume_1

/dev/md2: read failed after 0 of 4096 at 0: Input/output error

/dev/md2: read failed after 0 of 4096 at 3989805203456: Input/output error

/dev/md2: read failed after 0 of 4096 at 3989805260800: Input/output error

/dev/md2: read failed after 0 of 4096 at 4096: Input/output error

Volume group "vg1-volume_1" not found

Cannot process volume group vg1-volume_1

dementsprechend geht auch

sudo mdadm --stop /dev/md2

mdadm: Cannot get exclusive access to /dev/md2

erhaps a running process, mounted filesystem or active volume group?

erhaps a running process, mounted filesystem or active volume group?nicht.

Die 2 vg auf md2 sind noch angelegt: vg1-syno_vg_reserved_area vg1-volume_1

irgend ne idee wie ich ohne lsof anzeigen lassen könnte was die vg noch belegt?

- Registriert

- 16. Sep. 2022

- Beiträge

- 1.166

- Reaktionspunkte

- 470

- Punkte

- 109

Du kannst die Daten ja auch erst löschen, wenn die Platten in der NAS sind. Oder verstehe ich den Satz falsch?die platten sind nicht mehr in der NAS und ich kann nichts löschen

lsof installiert bekommen

lsof | grep volume1

lsof: WARNING: can't stat() fuse.synodedup-fused file system /volume1/ActiveBackupforBusiness/ActiveBackupData

Output information may be incomplete.

lsof: WARNING: can't stat() fuse.synodedup-fused file system /volume3/Backup/ActiveBackupData

Output information may be incomplete.

ls /volume1

ls: cannot access '/volume1/@SynoFinder-etc-volume': Input/output error

ls: cannot access '/volume1/@config_backup': Input/output error

ls: cannot access '/volume1/@resource-monitor': Input/output error

ls: cannot access '/volume1/@systemd-journal.synology_r1000_rs422+.42661.core.gz': Input/output error

ls: cannot access '/volume1/@synonode.synology_r1000_rs422+.42661.core.gz': Input/output error

ls: cannot access '/volume1/@abk-agentless-s.synology_r1000_rs422+.42661.core.gz': Input/output error

@abk-agentless-s.synology_r1000_rs422+.42661.core.gz @appconf @appstore @database @S2S @synonode.synology_r1000_rs422+.42661.core.gz @userpreference

@ActiveBackup @appdata @apptemp @eaDir @SynoFinder-etc-volume @systemd-journal.synology_r1000_rs422+.42661.core.gz

ActiveBackupforBusiness @apphome @config_backup @resource-monitor @SynoFinder-log @tmp

lsof | grep volume1

lsof: WARNING: can't stat() fuse.synodedup-fused file system /volume1/ActiveBackupforBusiness/ActiveBackupData

Output information may be incomplete.

lsof: WARNING: can't stat() fuse.synodedup-fused file system /volume3/Backup/ActiveBackupData

Output information may be incomplete.

ls /volume1

ls: cannot access '/volume1/@SynoFinder-etc-volume': Input/output error

ls: cannot access '/volume1/@config_backup': Input/output error

ls: cannot access '/volume1/@resource-monitor': Input/output error

ls: cannot access '/volume1/@systemd-journal.synology_r1000_rs422+.42661.core.gz': Input/output error

ls: cannot access '/volume1/@synonode.synology_r1000_rs422+.42661.core.gz': Input/output error

ls: cannot access '/volume1/@abk-agentless-s.synology_r1000_rs422+.42661.core.gz': Input/output error

@abk-agentless-s.synology_r1000_rs422+.42661.core.gz @appconf @appstore @database @S2S @synonode.synology_r1000_rs422+.42661.core.gz @userpreference

@ActiveBackup @appdata @apptemp @eaDir @SynoFinder-etc-volume @systemd-journal.synology_r1000_rs422+.42661.core.gz

ActiveBackupforBusiness @apphome @config_backup @resource-monitor @SynoFinder-log @tmp

Du kannst die Daten ja auch erst löschen, wenn die Platten in der NAS sind. Oder verstehe ich den Satz falsch?

ich möchte die vg löschen und die md stoppen, kann dazu aber nicht mehr die alten platten ins system einlegen.

tschortsch

Benutzer

- Registriert

- 16. Dez. 2008

- Beiträge

- 1.655

- Reaktionspunkte

- 35

- Punkte

- 74

tschortsch

Benutzer

- Registriert

- 16. Dez. 2008

- Beiträge

- 1.655

- Reaktionspunkte

- 35

- Punkte

- 74

Wenn beide stecken dann kannst du es ja trotzdem einzeln mit fdisk löschen. Nachher würd ich halt mal neu starten.

- Registriert

- 27. Sep. 2008

- Beiträge

- 15.491

- Reaktionspunkte

- 4.773

- Punkte

- 533

Mir ist noch nicht ganz klar, was du da unter /volume1 siehst. Ist da überhaupt was rein gemountet? Wenn ja, was? (s. "mount")

Vielleicht haben da ja irgendwelche Pakete was reingeschrieben ohne dass da was gemountet ist.

Aber du willst ja /dev/md2 loswerden, da es keine Platten mehr umfasst (s. cat /proc/mdstat). War das wirklich ein Raid1 oder ein SHR? Vielleicht sitzt da noch ein LVM drüber, das erst noch weg muss.

Check mal mit "pvdisplay", "vgdisplay" und "lvdisplay", ob du was zu /dev/md2 findest.

Ich hab mal vor längerer Zeit mit mdadm und LVM auf einer Ubuntu-VM rumgespielt, um besser zu verstehen, was da Synology bei ihrem SHR so treibt.

Hier mal mein Mitschrieb:

Ein Rückbau müsste also in umgekehrter Reihenfolge stattfinden, also mit umount, lvremove, vgremove, pvremove, mdadm --stop

Vielleicht hilft dir das weiter.

Vielleicht haben da ja irgendwelche Pakete was reingeschrieben ohne dass da was gemountet ist.

Aber du willst ja /dev/md2 loswerden, da es keine Platten mehr umfasst (s. cat /proc/mdstat). War das wirklich ein Raid1 oder ein SHR? Vielleicht sitzt da noch ein LVM drüber, das erst noch weg muss.

Check mal mit "pvdisplay", "vgdisplay" und "lvdisplay", ob du was zu /dev/md2 findest.

Ich hab mal vor längerer Zeit mit mdadm und LVM auf einer Ubuntu-VM rumgespielt, um besser zu verstehen, was da Synology bei ihrem SHR so treibt.

Hier mal mein Mitschrieb:

Code:

# /dev/md2 als Raid1 erstellen

mdadm --create --verbose /dev/md2 --level=1 --raid-devices=2 /dev/sdb /dev/sdc

# LVM auf /dev/md2 setzen

pvcreate /dev/md2

vgcreate vg1000 /dev/md2

# 2 Logical Volumes anlegen

lvm

lvm> lvcreate –size 200M vg1000

lvm> lvcreate –size 300M vg1000

lvm> exit

# ... formatieren

mkfs.ext4 /dev/vg1000/lvol0

mkfs.ext4 /dev/vg1000/lvol1

# ... und mounten

mkdir /volume1

mount /dev/vg1000/lvol0 /volume1

mkdir /volume2

mount /dev/vg1000/lvol1 /volume2Vielleicht hilft dir das weiter.

- Registriert

- 27. Sep. 2008

- Beiträge

- 15.491

- Reaktionspunkte

- 4.773

- Punkte

- 533

Ja, ich hab's gesehen. Trotzdem musst du erst mal den Zusammenhang verstehen, bevor du anfängst irgendwas zu removen.

Der Rückbau muss in der richtigen Reihenfolge erfolgen, s. vorletzter Satz in #18

Der Rückbau muss in der richtigen Reihenfolge erfolgen, s. vorletzter Satz in #18

- Status

- Für weitere Antworten geschlossen.

Kaffeautomat

Wenn du das Forum hilfreich findest oder uns unterstützen möchtest, dann gib uns doch einfach einen Kaffee aus.

Als Dankeschön schalten wir deinen Account werbefrei.