a-tom

Benutzer

- Registriert

- 05. Nov. 2014

- Beiträge

- 129

- Reaktionspunkte

- 26

- Punkte

- 34

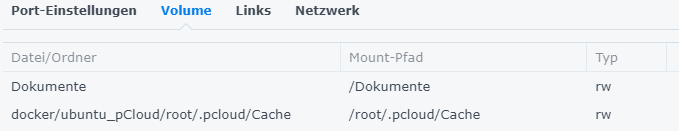

Habe jetzt mal ubuntu 22.04 als Image genommen (minimal Install) und in Docker gestartet mit einem Volume zB /Dokumente (Freigegebener Ordner). Zugriff auf die Synology ist somit schon einmal möglich. (DSM 7.1.1-42962 Update 3)

Im Terminal dann ein Update gemacht und Netzwerktools installiert

Jetzt die Anleitung unter https://github.com/pcloudcom/console-client befolgt.

Also

Nach dem ersten Aufruf mit dem Befehl "pcloudcc -u username -p" treten Fehler mit Fuse auf und nach Recherche muss der Container mit hoher Priorität laufen (--privileged), dies stellt man unter den "Allgemeinen Einstellungen" mit der Checkbox "Container mit hoher Priorität laufen lassen" ein.

Zusätzlich muss für Fuse noch eine Umgebungsvariable "security-opt apparmor=unconfined" gesetzt werden, damit das Linux Security Modul nicht anschlägt.

Nachdem jetzt alle Fehlermeldungen beseitigt sind, kann mit

gestartet werden.

-u pCloud-User

-p Eingabe Passwort

-d als Deamon starten (im Hintergrund laufen lassen)

-m Mountpoint

Jetzt kann ich unter /pcloud meine pCloud Daten sehen und unter /Dokumente meine Synology-Freigabe.

Ein erster Test mit rsync zeigt, dass es recht fix geht.

Installation mit

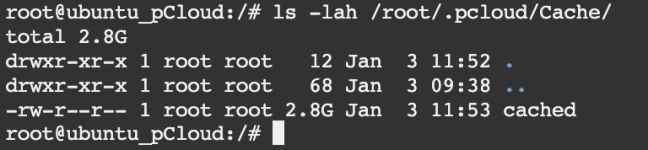

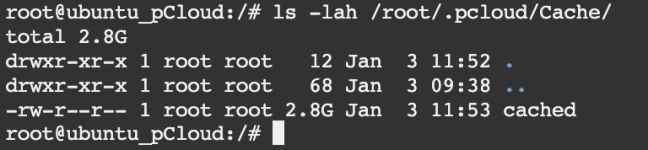

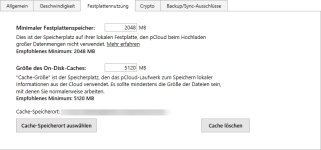

Ein weiterer Test mit pv für die Geschwindigkeitsanzeige zeigt, dass die Datei(en) erst in einem Zwischencache geladen und dann im Hintergrund hochgeladen wird. Die Geschwindigkeit entspricht meinem Anschluss (50Mbit/s Upload).

Die Anleitung erwähnt hier auch diesen Punkt.

Erkenntnis: Nur bei großen Dateien bleibt diese "cached" Datei im Ordner, kleinere Dateien werden sofort aus dem Cacheordner gelöscht.

ToDo:

- rsync mit crontab einrichten

- cached-Datei nach dem kopieren löschen

- Zugriff Cryptoordner

Im Terminal dann ein Update gemacht und Netzwerktools installiert

Code:

apt-get update

apt-get install net-toolsAlso

Code:

apt-get install cmake zlib1g-dev libboost-system-dev libboost-program-options-dev libpthread-stubs0-dev libfuse-dev libudev-dev fuse build-essential git

mkdir console-client

git clone https://github.com/pcloudcom/console-client.git ./console-client/

cd ./console-client/pCloudCC/

cd lib/pclsync/

make clean

make fs

cd ../mbedtls/

cmake .

make clean

make

cd ../..

cmake .

make

make install

ldconfigNach dem ersten Aufruf mit dem Befehl "pcloudcc -u username -p" treten Fehler mit Fuse auf und nach Recherche muss der Container mit hoher Priorität laufen (--privileged), dies stellt man unter den "Allgemeinen Einstellungen" mit der Checkbox "Container mit hoher Priorität laufen lassen" ein.

Zusätzlich muss für Fuse noch eine Umgebungsvariable "security-opt apparmor=unconfined" gesetzt werden, damit das Linux Security Modul nicht anschlägt.

Nachdem jetzt alle Fehlermeldungen beseitigt sind, kann mit

Code:

pcloudcc -u username -p -d -m /pcloud-u pCloud-User

-p Eingabe Passwort

-d als Deamon starten (im Hintergrund laufen lassen)

-m Mountpoint

Jetzt kann ich unter /pcloud meine pCloud Daten sehen und unter /Dokumente meine Synology-Freigabe.

Ein erster Test mit rsync zeigt, dass es recht fix geht.

Installation mit

Code:

apt-get install rsyncEin weiterer Test mit pv für die Geschwindigkeitsanzeige zeigt, dass die Datei(en) erst in einem Zwischencache geladen und dann im Hintergrund hochgeladen wird. Die Geschwindigkeit entspricht meinem Anschluss (50Mbit/s Upload).

Die Anleitung erwähnt hier auch diesen Punkt.

Hier liegt dann auch nach dem kopieren die cached Datei rum.Current version of pcloudcc doesn't support command to check if threre are pending transfers. Locally cached files are located under ~/.pcloud/Cache dir. When there is only one file ~/.pcloud/Cache/cached (ususally big sized) this mean that transfers are completed.

Erkenntnis: Nur bei großen Dateien bleibt diese "cached" Datei im Ordner, kleinere Dateien werden sofort aus dem Cacheordner gelöscht.

ToDo:

- rsync mit crontab einrichten

- cached-Datei nach dem kopieren löschen

- Zugriff Cryptoordner

Anhänge

Zuletzt bearbeitet:

uns das Beste ist, die pCloud wird unterstützt

uns das Beste ist, die pCloud wird unterstützt