FritzBox 7590 (250 down / 50 up); opnsense Firewall Intel N150 + 16GB RAM + 500GB nvme + 2,5G

Diverse Ubiquiti 1G & 2,5G Switche mit 10G Uplink; 2x Ubiquiti U7 Pro Access Points

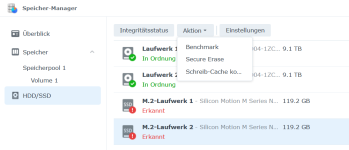

DS720+ DSM 7.3 (18GB RAM; 2x18TB Seagate Exos X18 SHR1 btrfs, 2x1TB WD Red SN700 nvme RAID1 btrfs; 2,5G); Proxmox Backup Server als VM

[Backup] DS218+ DSM 7.3 (12GB RAM; 6TB + 4TB WD Red Plus je als BASIC btrfs) + Hetzner Storage Box Offsite Backup + 18TB USB HDD

APC Back-UPS XS950U an Proxmox-Host mit NUT-Server / SNMP + Ansible

Proxmox-Hosts:

PVE1 (Intel Core i9-9980HK; 64GB RAM): 2x1TB nvme + 1TB sata SSD; 2,5GbE | 4 Windows VMs

PVE2

Lenovo ThinkCentre Tiny M710q (Intel Core i7-7700T; 64GB RAM): 512GB nvme + 1TB sata SSD | 6 Linux VMs

PVE3

Lenovo ThinkCentre Tiny M720q (Intel Core i5-9400T; 64GB RAM); 256GB nvme + 1TB sata SSD | 5 Linux VMs

Test-PVE

Lenovo ThinkCentre Tiny M720q (Intel Core i5-9400T; 32GB RAM): 256GB nvme + 512GB sata SSD + 2TB USB HDD