Hallo zusammen,

ich habe eine 1,5TB Samsung Festplatte (EcoGreen F4 HD154UI), die ich ehe ich sie abgebe sicher löschen möchte.

Da ich meine Rechner nicht so lange laufen lassen wollte, dachte ich das NAS, welches eh in Betrieb ist, wird dies ja auch verrichten können.

Also habe ich mich per SSH mit meiner DiskStation DS214+ verbunden, den Mountpoint der externen Platte identifiziert und dd gestartet:

Von einem zweiten Terminal Fenster aus habe ich die Process-ID mittels

für den nun laufenden dd-Prozess identifiziert.

Mittels

kann ich mir nun in erstem Terminal-Fenster die aktuell verarbeiteten Blöcke ausgeben lassen und das sieht mittlerweile so aus:

Gestartet wurde dieser dd-Kopierprozess am Mittwoch vor der Arbeit.

Ich habe keine Block-Size definiert, da ich den Wert nicht ermitteln konnte.

Hat mir dabei nicht weitergeholfen. Ich hab den Output gerade nicht zur Hand, aber ich meine es stand dort "unknown".

Ist die Standard-Blocksize von dd bei 1024Bytes oder gar nur 512Bytes?

Ich habe beides bereits bei Websuchen gelesen :/

Mit wievielen Blöcken kann ich nun rechnen?

bs=1024 (Bytes): 1,5 * 1024^3 = 1610612736 Blöcke

bs=512 (Bytes): 1,5 * 1024^3 *2 = 3221225472 Blöcke

Ersteres, 1024 Bytes, würde bedeuten, dass ich bei knapp (1103979173 / 1610612736 =) 68% der Gesamtbearbeitung wäre, richtig?

Letzteres, 512 Bytes, analog nur bei knapp (1103979173 / 3221225472 =) 34%?

Insgesamt ein sehr langes Unterfangen

Was wären denn eine für den nächsten "Überschreibvorgang" sinnvolle Block-Size? 4096?

Inwiefern beschleunigt dies den Kopiervorgang?

Ferner ist es überhaupt ratsam diesen Kopiervorgang von der DiskStation aus auszuführen?

Was hat überhaupt Einfluss auf die Performance?

Ich meine mich erinnern zu können, dass ich vor einiger Zeit mal eine 1TB Festplatte mittels DBAN (Darik's Boot and Nuke) Live-CD 7x hab mit Zufalls-Zahlen und anschließend mi Nullen überschreiben lassen, was insgesamt knappe 28 Stunden gedauert hat.

Das ist doch ein deutlicher Unterschied zu meiner oben beschriebenen "Performance" :/

Was macht den Unterschied aus?

Vielen Dank und liebe Grüße

ich habe eine 1,5TB Samsung Festplatte (EcoGreen F4 HD154UI), die ich ehe ich sie abgebe sicher löschen möchte.

Da ich meine Rechner nicht so lange laufen lassen wollte, dachte ich das NAS, welches eh in Betrieb ist, wird dies ja auch verrichten können.

Also habe ich mich per SSH mit meiner DiskStation DS214+ verbunden, den Mountpoint der externen Platte identifiziert und dd gestartet:

Rich (BBCode):

dd if=/dev/urandom of=/dev/sdq1Von einem zweiten Terminal Fenster aus habe ich die Process-ID mittels

Rich (BBCode):

ps | grep ddMittels

Rich (BBCode):

kill -USR1 <Process-ID>

Rich (BBCode):

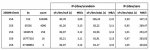

1103979173+1 records in

1103979173+1 records outGestartet wurde dieser dd-Kopierprozess am Mittwoch vor der Arbeit.

Ich habe keine Block-Size definiert, da ich den Wert nicht ermitteln konnte.

Rich (BBCode):

hdparm -I /dev/sdq1Ist die Standard-Blocksize von dd bei 1024Bytes oder gar nur 512Bytes?

Ich habe beides bereits bei Websuchen gelesen :/

Mit wievielen Blöcken kann ich nun rechnen?

bs=1024 (Bytes): 1,5 * 1024^3 = 1610612736 Blöcke

bs=512 (Bytes): 1,5 * 1024^3 *2 = 3221225472 Blöcke

Ersteres, 1024 Bytes, würde bedeuten, dass ich bei knapp (1103979173 / 1610612736 =) 68% der Gesamtbearbeitung wäre, richtig?

Letzteres, 512 Bytes, analog nur bei knapp (1103979173 / 3221225472 =) 34%?

Insgesamt ein sehr langes Unterfangen

Was wären denn eine für den nächsten "Überschreibvorgang" sinnvolle Block-Size? 4096?

Inwiefern beschleunigt dies den Kopiervorgang?

Ferner ist es überhaupt ratsam diesen Kopiervorgang von der DiskStation aus auszuführen?

Was hat überhaupt Einfluss auf die Performance?

Ich meine mich erinnern zu können, dass ich vor einiger Zeit mal eine 1TB Festplatte mittels DBAN (Darik's Boot and Nuke) Live-CD 7x hab mit Zufalls-Zahlen und anschließend mi Nullen überschreiben lassen, was insgesamt knappe 28 Stunden gedauert hat.

Das ist doch ein deutlicher Unterschied zu meiner oben beschriebenen "Performance" :/

Was macht den Unterschied aus?

Vielen Dank und liebe Grüße