- Registriert

- 19. Feb. 2016

- Beiträge

- 1.212

- Reaktionspunkte

- 235

- Punkte

- 89

Vielen Dank fuer Eure Einschaetzungen der Lage

Es gibt mittlerweile neue Ergebnisse:

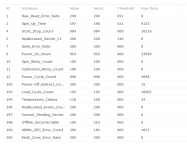

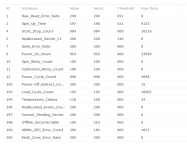

Der SMART Test der 5ten Platte brach immer mit "interrupted" ab. Daraufhin zogen wir die Platten 1-4 aus der Extension raus. Dann lief der SMART Test durch. Die Werte sehen aehnlich aus wie bei den anderen Platten. Es gibt auch wieder bei 199 Werte.

Auffaellig ist dass alle 5 Platten bei 199 Werte haben und nicht nur eine Platte. Das spricht dafuer dass wohl die Extension oder die Verbindung von der NAS dorthin ein Problem hat. Aehnliches vermutet Ihr ja auch: Entweder die Extension HW, das Kabel oder das Netzteil.

Was haben wir gemacht:

1) Das Verbindungskabel von NAS zur Extension mehrere Male aus- und eingesteckt um moegliche Kontakprobleme zu beseitigen

2) Die 5 Platten mehrere Male aus- und eingesteckt aus selbigen Gruenden

Wie kann man jetzt zuverlaessig pruefen ob die beiden Massnahmen etwas verbessert haben? Leider sind seit dem Ausfall des Storagepools keine IO Errors mehr im Log zu sehen. Waeren die weiterhin gekommen und jetzt ploetzlich weg waere das ein Indiz.

Bei den UDMA CRC Fehlern wird als moeglicher Grund genannt:

1) Kalte Loetstelle in der Extension

2) Staub im Gehaeuse

3) Kontaktprobleme

Interessanterweise wird nicht ein defektes Netzteil in dem Kontext genannt.

Wie wuerdet Ihr jetzt weiter vorgehen? Das Problem ist dass wir sicher sein wollen dass die Ursache beseitigt wird bzw wurde denn dem RAID5 vertrauen wir natuerlich nur dann. Ansonsten kann das Problem ja immer wieder auftreten.

Die Tatsache dass der SMART Test bei der 5ten Platte nur durchlaeuft wenn eine Platte drinsteckt weist irgendwie auf das Netzteil hin. Allerdings passt das nicht da die ersten 4 Platten getestet werden konnten als alle 5 Platten in der Extension steckten. Gibt es einen einfachen Weg das Netzteil zu pruefen?

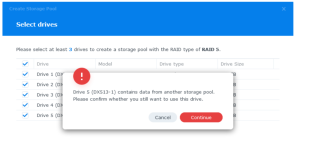

In dem Kontext mal eine andere Frage: Haetten wir jetzt eine weitere Extension und wuerden dort die 5 Platten reinstecken und an die NAS anschliessen: Wuerde das RAID5 wieder einen normalen Status bekommen oder muss das RAID5 neu initialisiert werden? Wie schon erwaehnt koennen von dem RAID5 ohne Probleme die Daten gelesen werden. Oder geht das nur vermittels mdadm als root auf der NAS dann man den Status des RAID5 wieder auf OK setzen kann?

Es gibt mittlerweile neue Ergebnisse:

Der SMART Test der 5ten Platte brach immer mit "interrupted" ab. Daraufhin zogen wir die Platten 1-4 aus der Extension raus. Dann lief der SMART Test durch. Die Werte sehen aehnlich aus wie bei den anderen Platten. Es gibt auch wieder bei 199 Werte.

Auffaellig ist dass alle 5 Platten bei 199 Werte haben und nicht nur eine Platte. Das spricht dafuer dass wohl die Extension oder die Verbindung von der NAS dorthin ein Problem hat. Aehnliches vermutet Ihr ja auch: Entweder die Extension HW, das Kabel oder das Netzteil.

Was haben wir gemacht:

1) Das Verbindungskabel von NAS zur Extension mehrere Male aus- und eingesteckt um moegliche Kontakprobleme zu beseitigen

2) Die 5 Platten mehrere Male aus- und eingesteckt aus selbigen Gruenden

Wie kann man jetzt zuverlaessig pruefen ob die beiden Massnahmen etwas verbessert haben? Leider sind seit dem Ausfall des Storagepools keine IO Errors mehr im Log zu sehen. Waeren die weiterhin gekommen und jetzt ploetzlich weg waere das ein Indiz.

Bei den UDMA CRC Fehlern wird als moeglicher Grund genannt:

1) Kalte Loetstelle in der Extension

2) Staub im Gehaeuse

3) Kontaktprobleme

Interessanterweise wird nicht ein defektes Netzteil in dem Kontext genannt.

Wie wuerdet Ihr jetzt weiter vorgehen? Das Problem ist dass wir sicher sein wollen dass die Ursache beseitigt wird bzw wurde denn dem RAID5 vertrauen wir natuerlich nur dann. Ansonsten kann das Problem ja immer wieder auftreten.

Die Tatsache dass der SMART Test bei der 5ten Platte nur durchlaeuft wenn eine Platte drinsteckt weist irgendwie auf das Netzteil hin. Allerdings passt das nicht da die ersten 4 Platten getestet werden konnten als alle 5 Platten in der Extension steckten. Gibt es einen einfachen Weg das Netzteil zu pruefen?

In dem Kontext mal eine andere Frage: Haetten wir jetzt eine weitere Extension und wuerden dort die 5 Platten reinstecken und an die NAS anschliessen: Wuerde das RAID5 wieder einen normalen Status bekommen oder muss das RAID5 neu initialisiert werden? Wie schon erwaehnt koennen von dem RAID5 ohne Probleme die Daten gelesen werden. Oder geht das nur vermittels mdadm als root auf der NAS dann man den Status des RAID5 wieder auf OK setzen kann?

Gehen wir mal davon aus dass das nicht die Ursache ist.

Gehen wir mal davon aus dass das nicht die Ursache ist. . Lassen wir den 199 mal im Hinterkopf aber aussen vor.

. Lassen wir den 199 mal im Hinterkopf aber aussen vor. D.h. man braucht keinen extended SMART Test dazu? Wie bekommt man sie sonst?

D.h. man braucht keinen extended SMART Test dazu? Wie bekommt man sie sonst?