Liebes Forum

Wir benutzen zwei Synology NAS und benutzen ShareSync um diese übers Internet zu spiegeln.

Dies klappte eigentlich ganz gut, heute ist es aber extrem langsam.

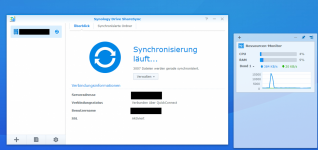

Hier ein Screenshot:

Normalerweise haben wir hier Verbindungsgeschwindigkeiten von mehreren MBs, heute sind wir aber nur im kB Bereich.

Es wurden viele kleine Dateien dem NAS hinzugefügt. Evtl. hat es damit Probleme?

Auch habe ich gelesen, dass die Verbindung über QuickConnect Probleme bereiten kann. Wobei das bei uns bis jetzt gut geklappt hat. Wenn ich das wechseln will eine Frage, kann ich eine Bestehende Verbindung anapssen? Wenn ich auf "Verbindung bearbeiten" klicke kann ich das QuickConnect/IP Feld nicht bearbeiten. Oder soll ich die jetzige Verbindung löschen und eine neue aufsetzen? Und wenn ich schon frage.. welche Ports müssen zwingend offen sein für die Synchronization direkt zur IP?

Bin über jeden Tipp dankbar!

Grüsse

Nelbar

Wir benutzen zwei Synology NAS und benutzen ShareSync um diese übers Internet zu spiegeln.

Dies klappte eigentlich ganz gut, heute ist es aber extrem langsam.

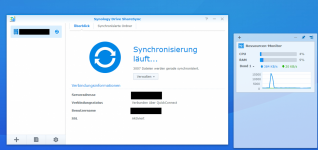

Hier ein Screenshot:

Normalerweise haben wir hier Verbindungsgeschwindigkeiten von mehreren MBs, heute sind wir aber nur im kB Bereich.

Es wurden viele kleine Dateien dem NAS hinzugefügt. Evtl. hat es damit Probleme?

Auch habe ich gelesen, dass die Verbindung über QuickConnect Probleme bereiten kann. Wobei das bei uns bis jetzt gut geklappt hat. Wenn ich das wechseln will eine Frage, kann ich eine Bestehende Verbindung anapssen? Wenn ich auf "Verbindung bearbeiten" klicke kann ich das QuickConnect/IP Feld nicht bearbeiten. Oder soll ich die jetzige Verbindung löschen und eine neue aufsetzen? Und wenn ich schon frage.. welche Ports müssen zwingend offen sein für die Synchronization direkt zur IP?

Bin über jeden Tipp dankbar!

Grüsse

Nelbar