Hallo,

Ich habe sehr viele duplizierte Daten, da ich vorher Backups vom System oder der Cloud einfach auf das Synology NAS 416 Plus mit BTRFS kopiert habe.

Nun habe ich entschieden aufzuräumen.

Snapshots habe ich nicht benutzt.

Dazu habe ich folgendes Programm vorgehabt.

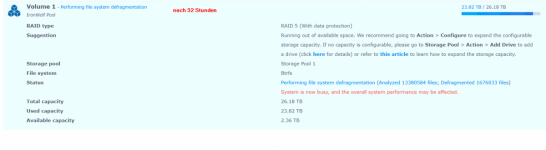

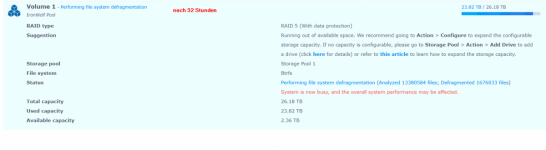

Schritt 3 scheint ca. 10 Tage zu dauern. 13 Mio Dateien , 1,7 Mio in 32 Stunden.

90% des NAS is belegt. Usage geht leicht runter dank Defrag (ohne Snapshots!).

Kein Anzeichen für Probleme, ausser dass es langsam ist.

Wie weiter?

A) Abbrechen und erst die Duplikate löschen. Wie abbrechen?

B) Duplicate gleichzeitig löschen (siehe auch hier )

C) 10 Tage warten

Ich habe sehr viele duplizierte Daten, da ich vorher Backups vom System oder der Cloud einfach auf das Synology NAS 416 Plus mit BTRFS kopiert habe.

Nun habe ich entschieden aufzuräumen.

Snapshots habe ich nicht benutzt.

Dazu habe ich folgendes Programm vorgehabt.

- Erstelle 10-12 Shared Folders für jeden Datentyp (wie Filme, Bilder, Programme, Music ...)

- Schiebe die Files in den richtigen Shared Folder

- Da 2 sehr langsam war, habe ich danach ein Defrag gestartet.

... Vielleicht ein wenig früh, da ich ja erst die Duplikate löschen müsste, siehe auch hier - Eliminiere die Duplikate pro Shared Folder (gleiche typen) mit Antitwin und Dropit

- Mach das Defrag nochmal .

Schritt 3 scheint ca. 10 Tage zu dauern. 13 Mio Dateien , 1,7 Mio in 32 Stunden.

90% des NAS is belegt. Usage geht leicht runter dank Defrag (ohne Snapshots!).

Kein Anzeichen für Probleme, ausser dass es langsam ist.

Wie weiter?

A) Abbrechen und erst die Duplikate löschen. Wie abbrechen?

B) Duplicate gleichzeitig löschen (siehe auch hier )

C) 10 Tage warten